人工智能消耗了惊人的电量– MIT系统降低了碳足迹

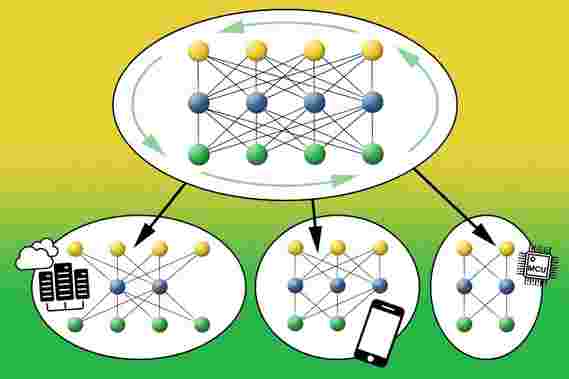

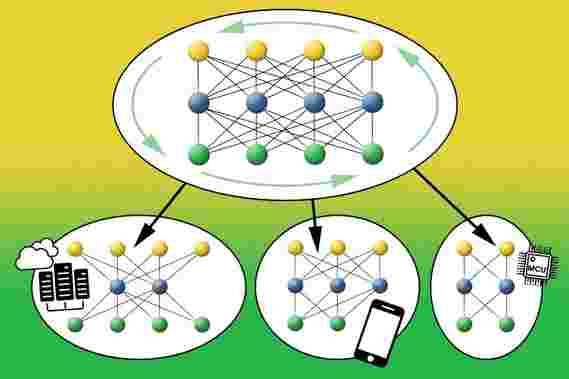

麻省理工学院的研究人员开发了一种新的自动化AI系统,该系统具有更高的计算效率和更小的碳足迹。研究人员的系统训练了一个大型神经网络,其中包括许多不同大小的预先训练的子网络,这些子网络可以针对特定的硬件平台进行定制,而无需重新训练。

MIT系统减少了训练和运行神经网络所需的能量。

人工智能已经成为某些道德关注的焦点,但它也存在一些重大的可持续性问题。

去年6月,马萨诸塞州大学阿默斯特分校的研究人员发布了一份惊人的报告,估计训练和搜索某种神经网络体系结构所需的电量涉及大约626,000磅的二氧化碳排放量。这相当于包括制造在内的美国普通汽车的全生命周期排放量的将近五倍。

这个问题在模型部署阶段变得更加严重,在深度部署阶段,深度神经网络需要部署在各自的硬件平台上,每个平台具有不同的属性和计算资源。

麻省理工学院的研究人员开发了一种新的自动化AI系统,用于训练和运行某些神经网络。结果表明,通过以某些关键方式提高系统的计算效率,该系统可以减少所涉及的碳排放量,在某些情况下,可以降低到低三位数。

研究人员的系统被称为“千篇一律的网络”,它训练一个大型神经网络,其中包括许多不同大小的预先训练的子网络,这些子网络可以针对永久的硬件平台进行定制而无需重新训练。这极大地减少了为新平台训练每个专门的神经网络通常所需的能量,而新的平台可能包括数十亿个物联网(IoT)设备。他们使用该系统训练计算机视觉模型,估计与当今最先进的神经体系结构搜索方法相比,该过程需要大约1 / 1,300的碳排放量,同时将推理时间减少了1.5-2.6倍。

“目标是建立更小,更绿色的神经网络,”电气工程和计算机科学系的助理教授宋寒说。到目前为止,搜索有效的神经网络架构具有巨大的碳足迹。但是,通过这些新方法,我们将足迹减少了几个数量级。

这项工作是在Satori上进行的,Satori是IBM捐赠给MIT的高效计算集群,它能够每秒执行2次四千万次计算。该论文将于下周在国际学习代表大会上发表。与Han一同参加的还有来自EECS,MIT-IBM Watson AI Lab和上海交通大学的四名本科生和研究生。

创建一个“一次所有人”的网络

研究人员在最近的AI进步AutoML(用于自动机器学习)上构建了该系统,从而消除了手动网络设计。神经网络会自动搜索大量的设计空间,以寻找适合于特定硬件平台的网络体系结构。但是仍然存在培训效率问题:必须选择每种模型,然后从头开始对其平台架构进行培训。

“我们如何针对如此广泛的设备(从10美元的物联网设备到600美元的智能手机)有效地训练所有这些网络?鉴于物联网设备的泛滥,神经体系结构搜索的计算成本将激增。” Han说。

研究人员发明了一种AutoML系统,该系统仅训练一个大型的“一次全部”(OFA)网络(充当“母”网络),嵌套了从母网络中稀疏激活的大量子网络。OFA与所有子网共享所有已学习的权重-这意味着它们实质上是经过预先训练的。因此,每个子网都可以在推理时独立运行而无需重新训练。

该团队使用通用的架构配置(包括不同数量的层和“神经元”),适当的过滤器大小以及适当的输入图像分辨率,训练了通常用于图像处理任务的OFA卷积神经网络(CNN)。在给定特定平台的情况下,该系统将OFA用作搜索空间,以根据与平台的功率和速度限制相关的准确性和延迟权衡,找到最佳的子网。例如,对于物联网设备,系统将找到一个较小的子网。对于智能手机,它将选择更大的子网,但根据电池的使用寿命和计算资源的不同,结构也会有所不同。OFA将模型训练与架构搜索分离开,将一次性训练成本分布在许多推理硬件平台和资源约束

上。这依赖于“渐进收缩”算法,该算法有效地训练了OFA网络以同时支持所有子网。首先以最大的规模训练整个网络,然后逐步缩小网络的规模,以包括较小的子网。较小的子网在大型子网的帮助下进行了培训,以共同成长。最后,所有大小不同的子网都受支持,从而可以根据平台的功率和速度限制进行快速专业化。添加新设备时,它以零培训成本支持许多硬件设备。

研究人员发现,总的来说,一个OFA可以包含10亿多位数(即1后跟19个零)的体系结构设置,可能涵盖了所有需要的平台。但是训练OFA并对其进行搜索最终要比花费数小时训练每个平台的每个神经网络效率更高。而且,OFA不会影响准确性或推理效率。相反,它在移动设备上提供了最新的ImageNet准确性。而且,与最新的行业领先的CNN模型相比,研究人员表示,OFA可以提供1.5-2.6倍的加速比,并且精度更高。

韩说:“这是一项突破性技术。”“如果我们想在消费类设备上运行强大的AI,我们必须指出如何将AI缩小到最小尺寸。”

“该模型非常紧凑。看到OFA能够继续推动边缘设备上的高效深度学习的边界,我感到非常兴奋。”麻省理工学院-IBM Watson AI实验室的研究员Chuang Gan说,他是该论文的合著者。

“如果要继续快速发展AI,我们就需要减少对环境的影响,” IBM研究员,麻省理工学院-IBM Watson AI实验室成员John Cohn说。“开发使AI模型更小,更高效的方法的好处在于,这些模型可能还会表现更好。”

-

450开尔文处的15万亿个原子的量子纠缠具有“令人惊讶的结果”

2022-04-13 -

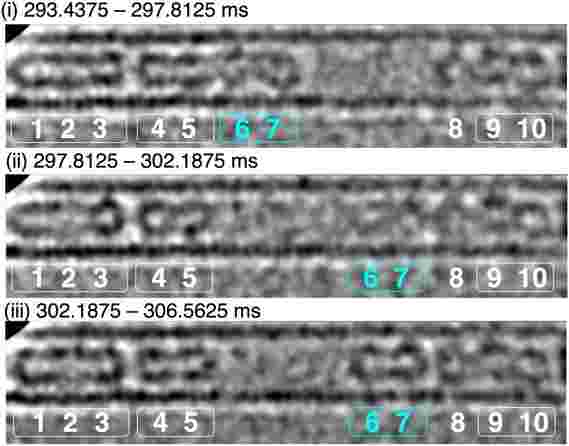

高速原子视频:以惊人的每秒1600帧的速度捕获单个分子

2022-04-13 -

基于激光的金属3D印刷中的突破会降低缺陷

2022-04-13 -

多功能智能电子眼镜监控健康,保护眼睛,控制视频游戏

2022-04-12 -

使用纳米结构的类似橡胶的材料创造了新的“人体组织替代物”

2022-04-11 -

耦合量子点可能提供一种存储量子信息的新方法

2022-04-10 -

新的石墨烯 - 碳纳米管催化剂可以点燃清洁能量旋转

2022-04-09 -

高科技隐形眼镜正确的颜色失明

2022-04-08 -

使用黑暗能量调查数据超越海王星的新小星球

2022-04-08 -

5周而不是50年:神经网络优化了对新材料的搜索

2022-04-08 -

干细胞技术通过擦拭他们的DNA清洁来恢复老人细胞

2022-04-08 -

“舞蹈猫热” - 鉴定为米纳塔汞中毒悲剧的新罪魁祸首

2022-04-08 -

基于激光的3D打印机成功生产出超级磁铁

2022-04-08 -

患者安全风险涉及“夸张”的AI优惠的医生

2022-04-07 -

斯坦福综合分析:酗酒者匿名最有效的酒精禁欲

2022-04-07

![鼠标大脑的全新完整,高分辨率3D地图[视频]](http://www.eastinstrument.com/uploadfile/2021/0601/202179942.jpg)