通过机器学习增强了先进光源同步rotron的光束性能

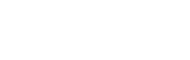

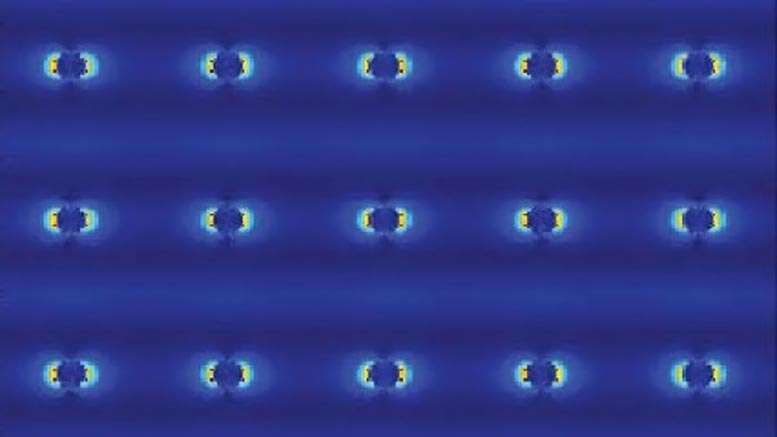

该图像显示伯克利实验室的高级光源同步rotron的电子束的配置文件,表示为由带电耦合器件(CCD)传感器测量的像素。当通过机器学习算法稳定时,光束的水平尺寸尺寸为49微米的均方平均和垂直尺寸为48微米的均方。苛刻的实验要求相应的光束尺寸在时间尺度范围内稳定,范围不到秒钟,以确保可靠的数据。

Synchrotron光源是强大的设施,通过加速电子在受控光束中发出光线来产生各种“颜色”或波长 - 从红外线产生光的强大设施。

像能源部劳伦斯伯克利国家实验室(伯克利实验室)的高级光源的同步罗朗

研究人员已经找到了升级这些机器的方法,以产生更强烈的,聚焦和一致的光束,这在广泛的样本类型中实现了新的,更复杂和更详细的研究。

但是一些光束特性仍然表现出对某些实验挑战的性能的波动。

解决数十年的问题

这些同步rotron设施中的许多功能不同类型的灯光有几种同时实验。并且在这些渗透光束线上提高光束性能的小调很少可以通过整个设施的整体光束性能。Synchrotron设计师和运营商已经摔跤了几十年,有多种方法可以弥补这些波动最顽固的方法。

现在,伯克利实验室和伯克利伯克利的一支大型研究人员已经成功地证明了机器学习工具如何通过在很大程度上取消这些波动的调整来提高光束尺寸的稳定性的实验 - 从一个水平降低它们百分比下降至0.4%,具有亚微米(低于100万米的米)精度。

该工具详述于2019年11月6日发布的学习中,在“物理审查信”中。

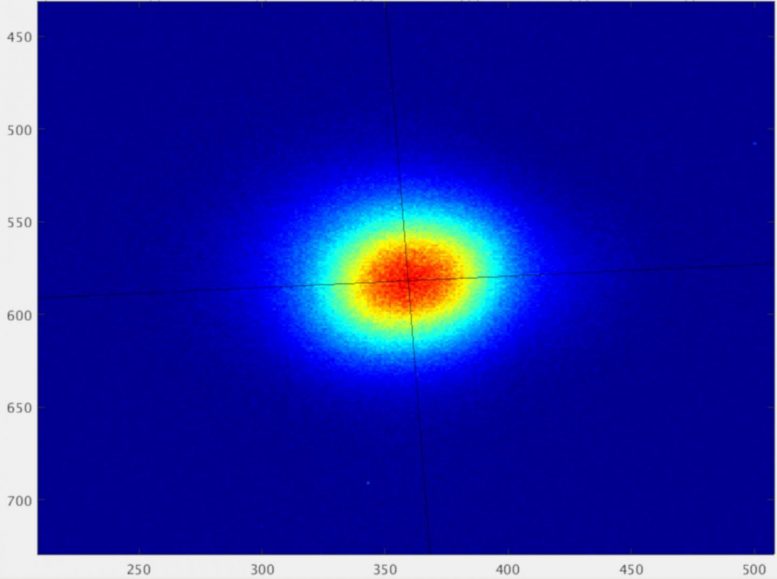

该图表显示了在高级光源操作期间实现神经网络时,垂直波束尺寸稳定性如何大大提高。当实现所谓的“前馈”校正时,垂直波束尺寸的波动从否则范围的水平稳定到副百分比(参见黄色突出显示的部分)。

机器学习是一种人工智能的形式,计算机系统分析一组数据以构建解决复杂问题的预测程序。在ALS上使用的机器学习算法被称为“神经网络”的形式,因为它们被设计成以松散地类似于人脑功能的方式识别数据中的模式。

在本研究中,研究人员从ALS馈送电子束数据,其中包括用于从电子束产生光的磁性装置的位置进入神经网络。该数据中的神经网络识别模式并识别不同的设备参数如何影响电子束的宽度。机器学习算法还建议对磁体进行调整以优化电子束。

因为电子束的尺寸反映了由磁铁产生的所得光束,所以该算法还优化了用于研究ALS的材料特性的光束。

解决方案可能具有全局影响

ALS的成功演示显示了该技术的方式通常也适用于其他光源,并且对通过称为ALS-U项目的ALS升级的专业研究特别有益。

“这是这一点的美丽,”去年退休的伯克利实验室联盟公司Hiroshi Nishimura表示,并从事早期讨论和探索机器学习解决方案,以长期的光束尺寸稳定性问题。“无论加速器是什么,无论传统的解决方案如何,这种解决方案都可以在那之上。”

Als Director说:“这对ALS和ALS-U非常重要的提前来说,Steve Kevan说:”这是一个非常重要的进步。多年来,我们对来自我们X射线显微镜的图像中的神器有困难。本研究提出了一种基于机器学习的新馈前方法,它在很大程度上解决了这个问题。“

ALS-U项目将从大约100微米的水平增加到10微米的光束窄焦点,并且还为一致,可靠的光束特性产生更高的需求。

机器学习技术在传统的解决方案上建立了几十年以来,自1993年开始的几十年来改善,并且依赖于沿着ALS环的磁体的恒定调整,以便实时补偿inpidual Beamlines的调整。

Nishimura是一名以上,曾在25年前在线推动的团队的一部分,他开始研究大约四四或五年前的加速器应用的机器学习工具的潜在应用。他的谈话扩展到伯克利实验室和UC伯克利的计算和加速器专家,两年前概念开始凝胶。

ALS操作期间的成功测试

研究人员在今年早些时候在Als戒指周围的两个不同地点上成功地测试了该算法。他们提醒ALS用户对新算法进行测试进行实验,并要求他们提供有关任何意外性问题的反馈。

“我们在今年4月到6月的用户行动中对用户行动进行了一致的考验,”2018年加入了机器学习团队的博士博物馆C. Nathan Melton表示,并与前UC伯克利研究生帅刘刘刘密切合作谁对努力做出大幅贡献,是该研究的共同作者。

Simon Leemann,Als和Als和机器学习努力的主要调查员的副局长副局长说:“我们没有对测试的任何负面反馈。使用的监控光束线路之一是使用的团队是一个诊断束线,不断测量加速器性能,另一个是实验主动运行的光束线。“Alex Hexemer是ALS和计划的高级科学家,用于计算,作为开发新工具的联合领导。

具有主动实验的光束线束线5.3.2.2使用称为扫描变速器X射线显微镜或STXM的技术,并且科学家们在实验中报道了改善的光束性能。

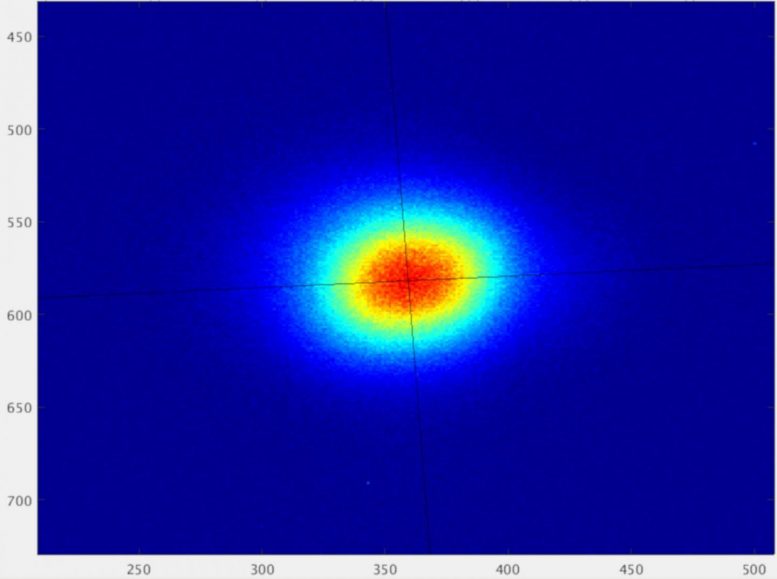

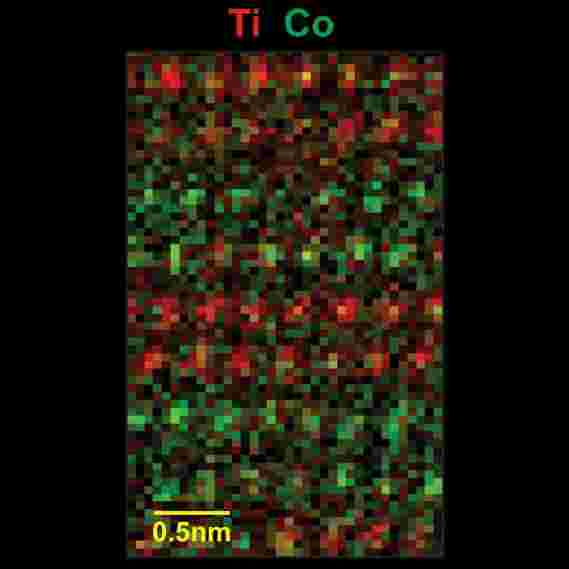

机器学习团队指出,增强的光束性能也非常适用于高级X射线技术,例如PTYChogume,可以将样品的结构分解为纳米的水平(亿米的亿米);和X射线光子相关光谱或XPC,这对于研究没有均匀结构的高浓缩材料的快速变化是有用的。

其他实验要求,其与样品相互作用的可靠性,高度聚焦光束的恒定强度也可以受益于机器学习增强,Leemann注意到。

“实验的要求正在变得更加强硬,样品上的较小区域扫描,”他说。“我们必须找到纠正这些不完美的新方法。”

他指出,光源社区已经摔跤的核心问题 - 以及机器学习工具地址 - 是光束线源点处的波动垂直电子束尺寸。

源点是光源处的电子束发射到特定光束线的实验的光的点。虽然电子束在此时的宽度自然稳定,但其高度(或垂直源尺寸)可以波动。

打开“黑匣子”的人工智能

“这是团队科学的一个非常好的例子,”莱曼说,注意到努力克服了一些关于机器学习的可行性的初始怀疑,以提高加速器性能,并打开了这些工具如何产生真正的好处的“黑匣子” 。

“这不是传统上是加速器社区的一部分的工具。我们设法将人们从两个不同的社区聚集在一起来解决一个非常艰难的问题。“大约15伯克利实验室研究人员参加了努力。

“机器学习从根本上提出了两件事:问题需要可重复,您需要大量数据,“莱曼说。“我们意识到我们可以将所有数据放入使用并具有算法识别模式。”

该数据显示电子束性能中的小漏分作为在inpidual波束线上进行调整,并且该算法发现一种方法来调整电子束,使得它比传统方法更好地熄灭这种影响。

“问题由大约35个参数组成 - 对我们来说太复杂了,”莱姆南说。“训练有素的神经网络做了什么 - 它给了我们一个对机器中的源大小发生的事情的预测,如果它完全没有什么可以纠正它。

“此模型中有一个额外的参数,该参数描述了我们在某种类型的磁铁中所做的更改如何影响该源大小。所以我们那么要做的就是选择 - 根据这个神经网络预测的参数 - 导致我们想要创建并将其应用于机器的光束大小,“leemann添加。

Leemann说,该算法定向系统现在可以以高达10秒的速度进行校正,速度最多可达10次,但似乎足以在此阶段提高性能。

搜索新的机器学习应用程序

机器学习团队于2018年8月从美国能源部获得两年的资金,以与Slac国家加速器实验室的斯坦福Synchrotron辐射光源合作追求这一和其他机器学习项目。“我们计划继续发展这一点,我们还有几种新的机器学习思想,我们想尝试一下,”莱曼说。

Nishimura说,流行语“人工智能”似乎已经遍历了研究界多年来,“这次终于似乎是真实的。”

###

参考:“通过S.C.Leemann,S. Hexemer,M.A.Marcus,C.N. Melton,H. Nishimura和C. Sun,2019年11月6日,物理审查信.DOI:

10.1103 / physrevlett.123.194801

先进的光源和斯坦福同步辐射光源是科学用户设施的Doe办事处。这项工作涉及伯克利实验室的计算研究司的研究人员,并得到了能源基本能源科学系和高级科学计算研究计划的支持。

-

自主机器人船改善了海上环境采样

2022-03-06 -

一颗星星诞生了:利用世界上最大的激光研究核酸合成

2022-03-04 -

NASA为土星卫星设计先进的变形机器人[视频]

2022-03-02 -

'Tunabot'揭开 - 第一个机器人鱼,以跟上金枪鱼[视频]

2022-02-28 -

超越GPS:毫米尺度位置跟踪

2022-02-28 -

演变为更好的模仿人类的机器人 - 可能在2020年选举中努力检测

2022-02-27 -

新的激光振动传感器从移动车辆中检测到埋地物体

2022-02-27 -

安全捕获新的超软机器人夹具水母[视频]

2022-02-26 -

研究人员建造的由肌肉和神经推动的微观生物混合机器人

2022-02-24 -

神经科学家:下一代人工智能的动物脑子

2022-02-22 -

“Macgyver”机器人可以通过评估物资来构建自己的工具

2022-02-21 -

新的形状改变机器人接受改变地形

2022-02-18 -

工程师用AI大脑创造智能机器人狗[视频]

2022-02-18 -

电子束一次操纵原子

2022-02-18 -

机器人螺纹通过脑血管磁阻磁阻[视频]

2022-02-17