人工智能使用“自学”,使癌症治疗减少毒性

麻省理工学院的研究人员旨在提高患有胶质母细胞瘤的患者的生活质量,具有最具侵略性的脑癌形式的患者,一种机器学习模型,使化疗和放射治疗剂量减少毒性,但仍然与人类设计的方案一样有效。

机器学习系统确定最少的,最小剂量仍然可以缩小脑肿瘤。

麻省理工学院研究人员正在采用新颖的机器学习技术,通过减少毒性化疗和放射治疗剂量的胶质母细胞瘤,最具侵略性的脑癌形式,以提高患者的生活质量。

胶质母细胞瘤是一种脑肿瘤,出现在大脑或脊髓中,而成人的预后不超过五年。患者必须忍受每月采取的放射治疗和多种药物的组合。医疗专业人员通常施用最大的安全药物剂量,尽可能地缩小肿瘤。但这些强有力的药物仍然导致患者的衰弱副作用。

在斯坦福大学的2018年医疗机会的2018年机器学习的一篇论文中,麻省理工学院媒体实验室研究人员详细介绍了一种可以使给药方案减少毒性但仍然有效的模型。由“自学”机器学习技术提供动力,模型看目前正在使用的治疗方案,并迭代调整剂量。最终,它发现了最佳的治疗计划,具有最低可能性和剂量的频率,仍然应该将肿瘤尺寸减少到与传统方案相当的程度。

在50名患者的模拟试验中,机器学习模型设计了治疗循环,使效力降低了几个或一半的几乎所有剂量,同时保持相同的肿瘤收缩潜力。很多时候,它完全跳过了剂量,每年只有两次而不是每月调度给行政管理。

“我们保留了目标,在那里我们必须通过减少肿瘤尺寸来帮助患者,但同时,我们希望确保生命的质量 - 给药毒性 - 不会导致压倒性和有害的副作用,” Pratik Shah表示,媒体实验室的主要调查员监督这项研究。

本文的第一作者是Media Lab研究员Gregory Yauney。

奖励良好的选择

研究人员的模型使用一种称为加强学习(RL)的技术,这是一种受行为心理学启发的方法,其中模型学会有利于某些导致期望结果的行为。

该技术包括人工智能的“代理”,在不可预测的复杂环境中完成“动作”以达到所需的“结果”。每当它完成动作时,代理商会收到“奖励”或“惩罚”,具体取决于行动是否朝着结果效力。然后,代理协助相应地调整其行动以实现该结果。

奖励和处罚基本上是积极的和负数,例如+1或-1。它们的价值观因采取的行动而变化,通过在结果中取得成果的概率或失败,以及其他因素来计算。该代理基本上尝试根据奖励和惩罚值来数字优化所有操作,以获得给定任务的最大结果分数。

该方法用于培训计算机程序深度,即2016年,为击败了游戏中世界上最好的人类球员之一的头条新闻。它还用于培养机动的无人驾驶汽车,如合并到交通或停车处,车辆将练习一遍又一遍地,调整其过程,直到它正确。

研究人员适用于使用药物替莫唑胺(TMZ)和ProCarbazine,Lomustine和Vincristine(PVC)的组合的胶质母细胞瘤治疗的RL模型,超过数周或数月。

该模型的代理梳理通过传统的管理方案。这些方案基于几十年来临床使用的方案,并基于动物测试和各种临床试验。肿瘤科医生使用这些建立的协议来预测基于重量给予患者的剂量。

随着模型探讨了方案,在每个计划的给药间隔时 - 例如每月一次 - 它决定了几个行动之一。首先,它可以启动或扣留剂量。如果它确实施用,则可以决定整个剂量,还是只需要一部分。在每次动作,它引起另一种临床模型 - 通常用于预测肿瘤的大小的变化,以响应治疗 - 看该动作是否缩小了平均肿瘤直径。如果确实,该模型会收到奖励。

然而,研究人员也必须确保该模型不仅仅是达到剂量的最大数量和效力。每当模型选择给管理所有全部剂量时,它会受到惩罚,所以反而选择较少,更小的剂量。“如果我们想要做的一切都会减少平均肿瘤直径,并让它采取任何想要的行动,它将不负责任地施用药物,”Shah说。“相反,我们说,”我们需要减少实现这一结果所需的有害行为。“

这代表了一个“非正统的RL模型,首次在论文中描述”,“Shah说,这重视潜在的作用(剂量)对结果(肿瘤减少)的潜在负面后果。传统的RL模型朝着单一的结果工作,例如赢得游戏,并采取最大化结果的任何和所有行动。另一方面,研究人员的模型在每种动作中都具有灵活性,以找到一种不一定能够最大化肿瘤减少的剂量,但在最大肿瘤减少和低毒性之间打击完美的平衡。他补充说,这种技术具有各种医疗和临床试验应用,必须对治疗患者进行治疗的动作以防止有害的副作用。

最佳方案

研究人员培训了50名模拟患者的模型,随机选自患有以前经历过传统治疗的胶质母细胞瘤患者的大型数据库。对于每位患者,该模型进行了大约20,000个试验和错误测试运行。一旦培训完成,就学习了最佳方案的型号参数。当给定新患者时,该模型使用这些参数来制定基于研究人员提供的各种约束的新方案。

然后,研究人员在50个新的模拟患者上测试了模型,并使用TMZ和PVC将结果与传统方案的结果进行比较。当没有剂量罚款时,该模型为人类专家设计了几乎相同的方案。然而,考虑到小而大的给药罚款,它基本上切割了剂量的频率和效力,同时还原肿瘤尺寸。

研究人员还设计了模型,以杂文治疗每只患者,以及单一的队列,并达到类似的结果(研究人员可获得每位患者的医疗数据)。传统上,将相同的给药方案应用于患者组,但肿瘤大小,医学历史,遗传谱和生物标志物的差异都可以改变患者如何治疗。沙阿说,在传统的临床试验设计和其他治疗中,这些变量不考虑在传统的临床试验设计和其他治疗中,往往导致对大型人群的疗法差。

“我们说[到模型],'你必须为所有患者提供同样的剂量吗?它说,'不。我可以向这个人提供四分之一的剂量,一半到这个人,也许我们跳过这个人的剂量。这是这项工作中最令人兴奋的部分,在那里我们能够通过使用非正统的机器学习架构进行单人试验来产生精确的药物治疗,“Shah说。

该模型提供了对饲养剂量的传统“眩晕”方法的重大改进,观察患者如何在J.Craig Venter Institute的人类生物学教授和人类主任的尼古拉斯J.Schork表示如何衡量和调整。临床试验设计专家。“[人类不要]有深入的看法,即看着大量数据的机器有,所以人类过程缓慢,乏味和不精确,”他说。“在这里,您只是让计算机在数据中查找模式,这将永远占据人类筛选,并使用这些模式来找到最佳剂量。”

Schork补充说,这项工作可能特别感兴趣的美国食品和药物管理局,目前正在寻求利用数据和人工智能发展卫生技术的方法。他说,“但我不怀疑在短时间内,FDA将如何适当地审查这些[技术],因此他们可以在日常临床计划中使用。”

-

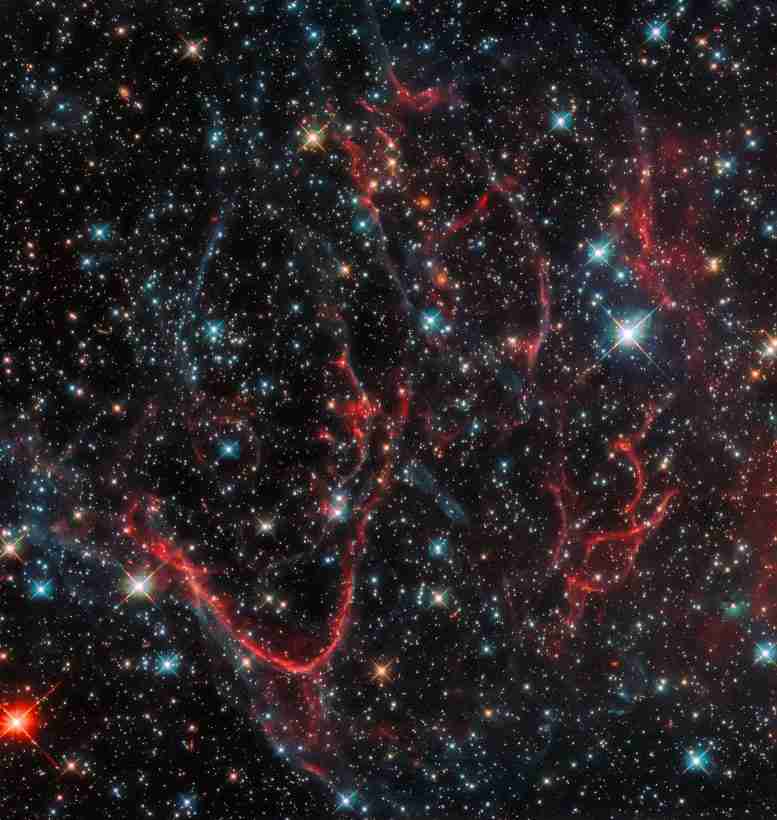

踩supernova resmnant cassiopeia a

2022-02-13 -

火星月亮Phobos如何获得奇怪的凹槽

2022-02-13 -

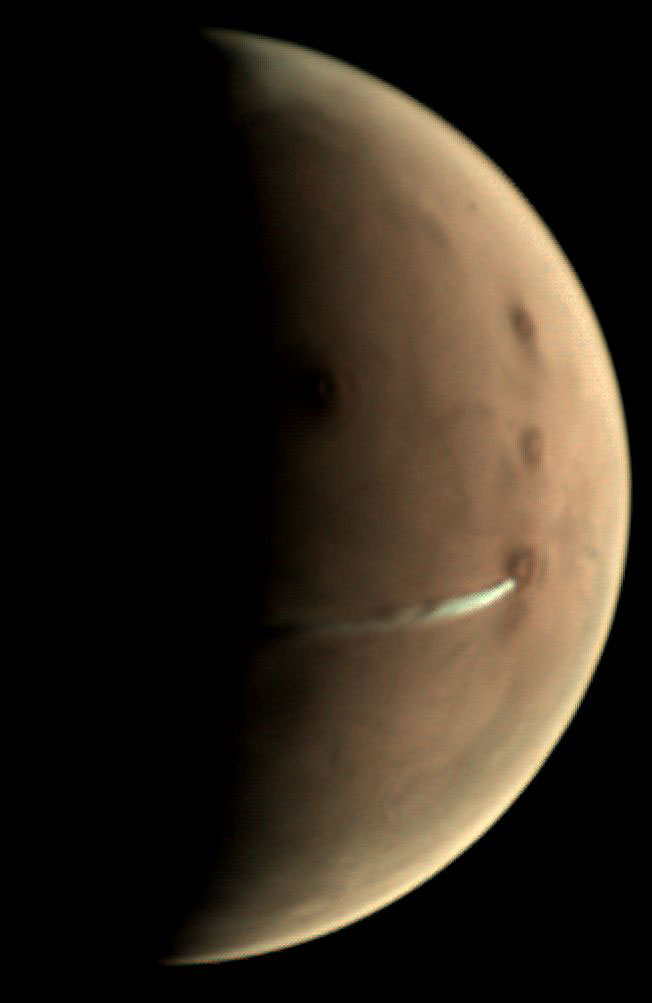

科学家揭示了Phytoplankton如何在营养缺乏海洋旋转中存活

2022-02-12 -

新的艾滋病毒疗法可增强免疫力并减少病毒复制

2022-02-07 -

天体物理学家创造新的方法来测量矮星系的暗物质

2022-02-05 -

美国国家航空航天局创造了第一个熔化雪花的3D模型

2022-02-05 -

基于脂质的纳米粒子使得囊性纤维化患者的改善治疗

2022-02-05 -

新的3D打印技术可实现更便宜的患者特异性医学研究

2022-02-05 -

“有目的”设备可以直接向心脏传递药物

2022-02-04 -

癫痫患者的新技术微调治疗

2022-02-02 -

科学家确定了对男性发育至关重要的基因

2022-02-02 -

机器学习系统复制人类听觉行为,预测脑反应

2022-01-31 -

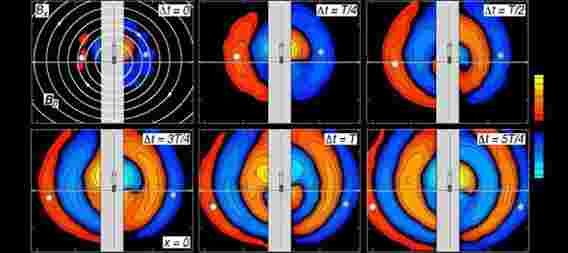

NASA卫星以3D方式重现太阳CME爆发

2022-01-30 -

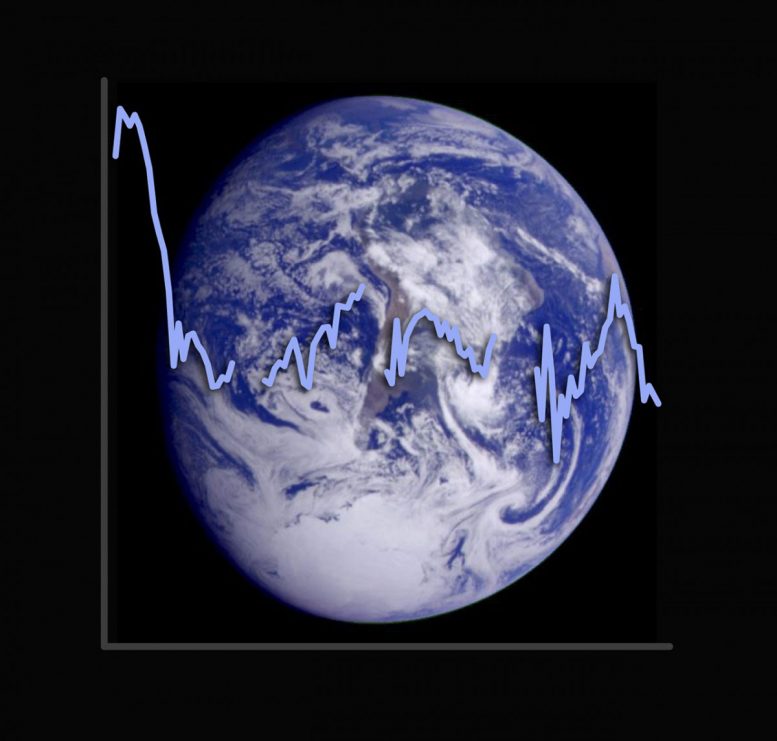

气候模型低估了云的冷却效果

2022-01-29 -

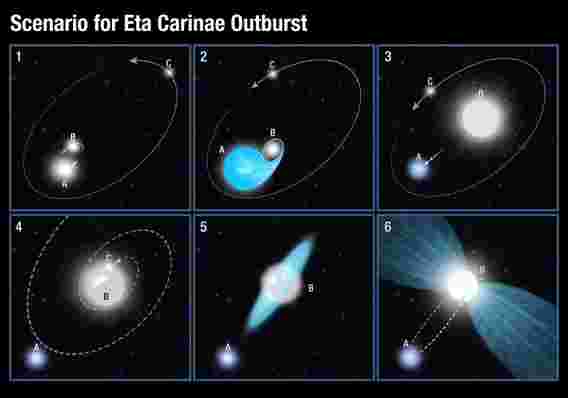

六十年的现代宇宙学的演变

2022-01-29